Heimliches LLM-Grooming: Wie KI-Chatbots mit Falschinformationen manipuliert werden

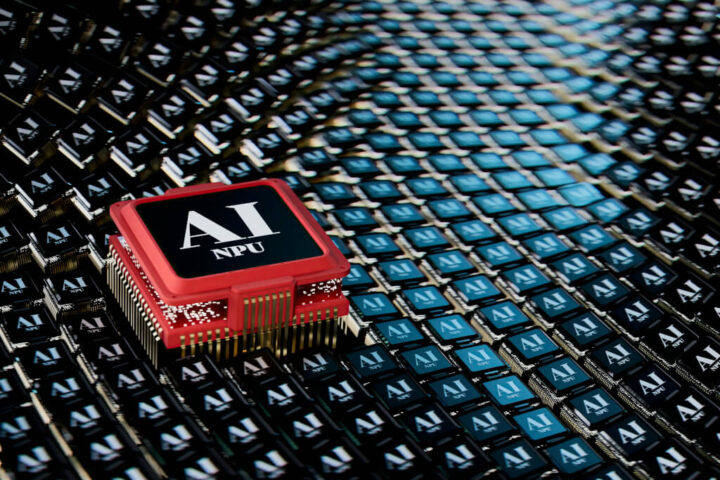

Künstliche Intelligenz bestimmt zunehmend unseren digitalen Alltag. Besonders Chatbots wie ChatGPT, Gemini oder Claude gehören für viele Menschen bereits zur täglichen Routine. Doch während wir Fragen stellen und Antworten erhalten, läuft im Hintergrund ein beunruhigender Prozess: das sogenannte „LLM-Grooming“ – eine gezielte Manipulation von KI-Systemen, die weitreichende Konsequenzen haben kann.

Eine aktuelle Studie weist nun darauf hin, dass besonders Propagandaportale gezielt Falschinformationen verbreiten, die von KI-Systemen aufgenommen und ungeprüft weitergegeben werden. Ein Problem, das vor allem jene Chatbots betrifft, die über integrierte Internet-Suchfunktionen verfügen.

Was ist LLM-Grooming und wie funktioniert es?

Der Begriff „LLM-Grooming“ beschreibt den Prozess, bei dem große Sprachmodelle (Large Language Models, LLMs) durch gezielte Einspeisung von Fehlinformationen manipuliert werden. Anders als das klassische „Prompt Engineering“ oder „Jailbreaking“, bei dem Nutzer direkt versuchen, ein KI-System zu Regelbrüchen zu verleiten, arbeitet das LLM-Grooming subtiler und indirekter.

LLM-Grooming ist deshalb so gefährlich, weil die Manipulation nicht im Moment der Nutzung, sondern bereits lange vorher stattfindet – und für den Endnutzer völlig unsichtbar bleibt.

Dr. Emily Carter, Forscherin für KI-Sicherheit

Die Manipulation funktioniert in mehreren Schritten:

- Erstellung von Falschinformationen: Akteure erstellen gezielt irreführende oder falsche Inhalte

- Veröffentlichung auf mehreren Websites: Die Inhalte werden auf verschiedenen Plattformen platziert, um Glaubwürdigkeit zu suggerieren

- Suchmaschinenoptimierung: Die Inhalte werden so aufbereitet, dass sie von Suchmaschinen gut gefunden werden

- KI-Übernahme: KI-Systeme mit Internetsuche greifen auf diese Quellen zu und behandeln sie als legitime Informationen

Die russische Propaganda-Studie: Ein konkretes Beispiel

Eine kürzlich veröffentlichte Untersuchung der Stanford Internet Observatory hat aufgedeckt, wie russische Propagandaportale systematisch Falschinformationen verbreiten, die dann von KI-Systemen aufgenommen werden. Die Forscher fanden heraus, dass Websites wie „RT“ (ehemals Russia Today) und „Sputnik News“ gezielte Desinformationskampagnen durchführen, die besonders bei Themen wie dem Ukraine-Krieg, westlichen Demokratien oder geopolitischen Konflikten zum Tragen kommen.

Besonders beunruhigend: Wenn Nutzer Chatbots mit Suchfunktion nach diesen Themen fragen, beziehen die KI-Systeme häufig Informationen von genau diesen Quellen – ohne die Nutzer über die fragwürdige Herkunft zu informieren.

Welche KI-Systeme sind besonders anfällig?

Nicht alle KI-Chatbots sind gleichermaßen anfällig für LLM-Grooming. Die Faktoren, die das Risiko beeinflussen, sind vor allem:

| KI-System | Internetanbindung | Quellenüberprüfung | Anfälligkeit für Grooming |

|---|---|---|---|

| ChatGPT mit Browsing | Ja | Mittel | Hoch |

| Gemini (ehemals Bard) | Ja | Mittel bis hoch | Mittel |

| Claude mit Suchfunktion | Ja | Mittel | Mittel bis hoch |

| Bing Chat | Ja | Mittel | Hoch |

| ChatGPT ohne Browsing | Nein | n/a | Niedrig* |

* Anfällig nur für Training-Daten-Verzerrungen, nicht für Echtzeit-Grooming

Besondere Risiken bestehen bei KI-Systemen, die:

- Aktiven Zugriff auf das Internet haben

- Keine oder nur begrenzte Quellenprüfungsmechanismen besitzen

- Suchfunktionen nutzen, die auf kommerzielle Suchmaschinen zurückgreifen

- Nutzeraktivitäten zur kontinuierlichen Verbesserung verwenden

Wie manipulierte KIs den öffentlichen Diskurs beeinflussen

Die Auswirkungen von LLM-Grooming gehen weit über technische Probleme hinaus. Sie können ernsthafte gesellschaftliche Konsequenzen haben:

Die Folgen reichen von der Verstärkung politischer Polarisierung über die Unterminierung demokratischer Prozesse bis hin zur gezielten Manipulation der öffentlichen Meinung. Besonders besorgniserregend: Da immer mehr Menschen KI-Systeme als primäre Informationsquelle nutzen, können manipulierte Antworten einen erheblichen Einfluss auf die Meinungsbildung haben.

Der renommierte Technologieethiker Prof. Mark Hansen von der Columbia University warnt: „Wenn wir KI-Systemen blind vertrauen, während sie im Hintergrund manipuliert werden, überantworten wir unsere Informationsökosysteme an genau jene Akteure, vor denen wir uns schützen sollten.“

Wie reagieren die Tech-Unternehmen?

Die großen KI-Entwickler wie OpenAI, Google und Anthropic haben das Problem erkannt und arbeiten an Lösungen:

- OpenAI hat kürzlich einen verbesserten Quellenbewertungsalgorithmus eingeführt und arbeitet an transparenteren Zitierungssystemen

- Google hat für Gemini eine erweiterte Quellenprüfung angekündigt, die verdächtige Websites identifizieren soll

- Anthropic experimentiert mit „epistemischer Unsicherheit“, wobei Claude bei potenziell manipulierten Themen Ungewissheit signalisieren soll

Dennoch: Viele Experten sehen diese Maßnahmen als unzureichend an. Die Coalition for AI Disinformation Prevention fordert strengere Regeln und bessere Transparenz darüber, welche Quellen KI-Systeme nutzen.

Wie können sich Nutzer schützen?

Während die Anbieter an technischen Lösungen arbeiten, gibt es einige Strategien, die Nutzer anwenden können, um sich vor manipulierten KI-Antworten zu schützen:

- Multiperspektivische Recherche: Vertraue nie auf eine einzige KI-Quelle – vergleiche Antworten verschiedener Systeme

- Quellenüberprüfung: Frage die KI stets nach den Quellen ihrer Informationen und überprüfe diese selbst

- Kritische Betrachtung: Behandle KI-Antworten zu politischen oder kontroversen Themen mit besonderer Vorsicht

- Zeitliche Einordnung: Achte darauf, wann die Informationen der KI zuletzt aktualisiert wurden

- Spezifische Prompts: Formuliere präzise Anfragen mit dem Wunsch nach ausgewogenen Antworten

Ein besonders effektiver Prompt könnte sein: „Bitte gib mir Informationen zu [Thema] aus verschiedenen Perspektiven, mit Angabe der Quellen und einer Einschätzung ihrer Zuverlässigkeit.“

Technische Lösungsansätze für die Zukunft

Für eine langfristige Lösung des Problems arbeiten Forscher an verschiedenen technischen Ansätzen:

- Quellenreputation: Systeme zur Bewertung der Vertrauenswürdigkeit von Quellen

- Faktenprüfung in Echtzeit: Integration von automatisierten Fact-Checking-Tools

- Diversitätsmaße: Algorithmen, die Einseitigkeit in Quellen erkennen können

- Transparente Zitierung: Klare Kennzeichnung aller genutzten Quellen im KI-Output

- Kollektive Moderation: Crowdsourcing-Ansätze zur Identifizierung problematischer Antworten

Fazit: Ein Wettlauf zwischen Manipulation und Schutzmaßnahmen

LLM-Grooming stellt eine ernsthafte Herausforderung für die Zuverlässigkeit und Vertrauenswürdigkeit von KI-Systemen dar. Es handelt sich um einen Wettlauf: Auf der einen Seite stehen Akteure, die KI-Systeme manipulieren wollen, auf der anderen Seite Entwickler und Forscher, die Schutzmechanismen etablieren möchten.

Die gute Nachricht: Das Bewusstsein für das Problem wächst. Sowohl die KI-Entwickler als auch Regulierungsbehörden wie die EU-Kommission mit ihrem AI Act haben das Problem erkannt und arbeiten an Lösungen.

Für uns als Nutzer bleibt vor allem eines wichtig: eine gesunde Portion Skepsis gegenüber KI-generierten Inhalten, insbesondere bei politisch oder gesellschaftlich kontroversen Themen.

Quellen:

- Stanford Internet Observatory: „LLMs and Disinformation“ (2023)

- Science: „Systematic manipulation of language models through proximal content“ (2023)

- OpenAI: „Measuring AI system reliability“ (2023)

- European Commission: „Regulatory framework on AI“

- Coalition for AI Disinformation Prevention: „Statement on LLM Manipulation“